Kuinka Google toimii?

Linkit ovat hakukonenäkyvyyden avain

Sivustolle tulevat linkit, ja niiden tuoman ”linkkivoiman” jakaantuminen ovat erittäin merkittävässä roolissa sivuston hakukonenäkyvyyden takaamiseksi.Mikä oikeastaan on Suomen suosituimman hakukoneen oma määritelmä itsestään? Vastaus on tyhjentävä:

Linkkivoima ja PageRank – yksinkertainen malli

Dokumenttien järjestys Googlessa perustuu pitkälti Larry Pagen ja Sergey Brinin kehittämään ja patentoimaan PageRank -algoritmiin, ja tässä on lyhyt ja yksinkertaistettu tiivistelmä siitä, kuinka PageRank toimii:

Oletetaan alkuun, että koko internetissä olisi vain neljä sivua (A,B,C,D), joista kolme (B,C ja D) linkittävät vain sivulle A. Jos lasketaan todennäköisyyksiä ja 1 tarkoittaa sitä, että 100%:n todennäköisyydellä satunnainen verkossa surffaaja päätyy jollekin sivulle, voidaan luku 1 jakaa näiden sivujen kesken, ja sen jälkeen laskea kuinka todennäköisesti käyttäjä päätyy kullekin sivulle. Lähtökohtaisesti ilman linkkejä jokaisen sivun todennäköisyys olisi siis 0.25.

Googlen robotti etenee verkossa linkkejä pitkin sivustolta toiselle. Mikäli kaikki sivut B,C ja D linkittävät sivulle A, on todennäköisyys sille, että satunnainen verkkosurffaaja päätyy sivulle A 0.75. Eli yksinkertaistettuna PageRank sivulle A olisi:

PR(A)=PR(B)+PR(C)+PR(D).

Helppoa? No eihän se tietenkään ole läheskään näin yksinkertaista – mutta tämä malli on hyvä pitää mielessä, kun mietitään kuinka Google ja sen robotit internetiä käsittelevät.

Google Page Rank ja sen kehitys

Vaikka edellinen, rankasti yksinkertaistettu mutta aikanaan suorastaan vallankumouksellinen malli, kuulostaa liiankin yksinkertaiselta niin totuus on se, että vielä tänäkin päivänä hakutulosten järjestys Googlessa pohjautuu linkkien määrälle sekä linkkien ja sivustojen keskinäisille suhteille. Kuten yleensäkin, niin myös linkeissä määrä ei korvaa laatua: linkittävän sivuston maineella, linkkien ”ankkuriteksteillä” ja linkkien asiayhteydellä sekä monilla muilla seikoilla on ratkaiseva merkitys siihen, mikä on kunkin sivun painoarvo tietyssä asiayhteydessä Googlen kannalta.

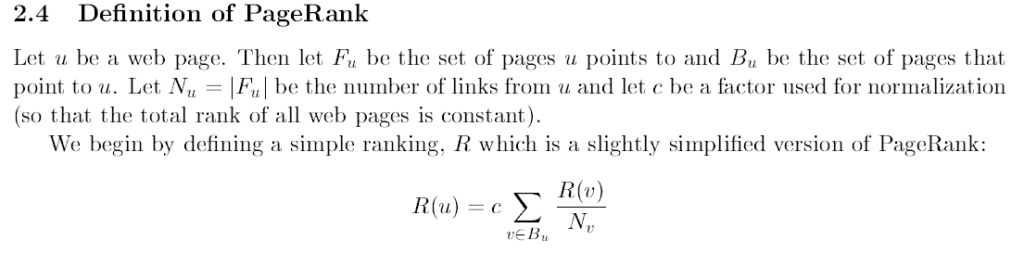

Alunperin PageRank -algoritmi perustui ”satunnaisen surffaajan mallille”, jolloin PageRank voitiin laskea yksinkertaistettuna seuraavalla mallilla (kuva aukeaa suurempana klikkaamalla):

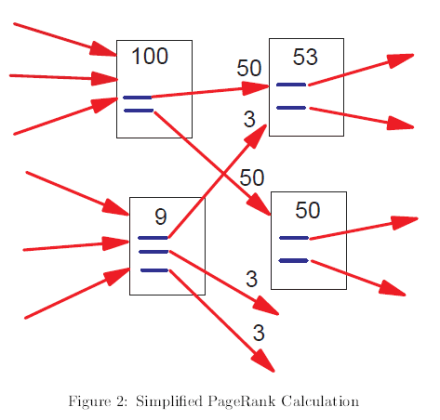

Kyseessä on siis Markovin ketju, ja (jälleen yksinkertaistettuna) Googlen algoritmi laskee matemaattisen todennäköisyyden sille, millä todennäköisyydellä netin käyttäjä päätyy tietylle sivulle. 1999 Stanfordin yliopistolla julkaistussa raportissaan The PageRank Citation Ranking: Bringing Order to the Web Page kollegoineen esittivät seuraavan kuvan siitä, kuinka PageRank voidaan yksinkertaisesti esittää:

Kyseessä on siis Markovin ketju, ja (jälleen yksinkertaistettuna) Googlen algoritmi laskee matemaattisen todennäköisyyden sille, millä todennäköisyydellä netin käyttäjä päätyy tietylle sivulle. 1999 Stanfordin yliopistolla julkaistussa raportissaan The PageRank Citation Ranking: Bringing Order to the Web Page kollegoineen esittivät seuraavan kuvan siitä, kuinka PageRank voidaan yksinkertaisesti esittää:

Viime vuosina Googlen algoritmiin on kuitenkin tehty useita merkittäviä muutoksia, joiden tarkoituksena on ollut parantaa hakutulosten laatua ja relevanssia. Googlen oman business-logiikan kannalta tämä onkin ensiarvoisen tärkeää: jos kukaan ei käyttäisi Googlea, olisi Googlen vaikea myydä myös mainostilaa hakutulosten yhteydessä!

Alussa esitetyn, aikanaan vallankumouksellisen ”satunnaisen surffaajan mallin” sijaan Google on pyrkinyt algoritmissaan yhä enemmän siihen suuntaan, että Googlen hakukoneessa viihtymisen ja hakutulosten satunnaisen selailun sijaan ihmisten hauilla on aina tietty tarkoitus tai aie. Tämä logiikan muutos on muuttanut sekä hakualgoritmia, että sivuston linkitysten merkityksiä. Ja jotta soppa ei olisi aivan niin yksinkertainen, on sosiaalisella medialla ja sen vaikutuksella omat seurauksensa myös Googlen algoritmin kehitykselle.

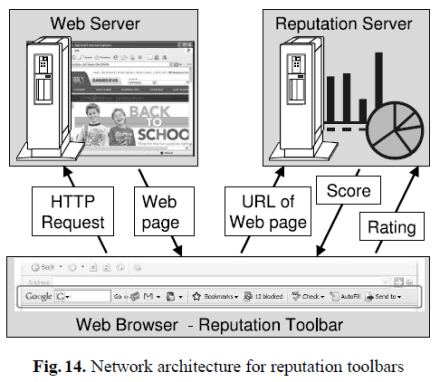

Alkuperäinen PageRank vs. PageRank 2011

Periaatteessa esimerkiksi Markovin ketjuja ja linkityssuhteita hyödyntämällä on edelleen mahdollista laskea käyttäjien todennäköisyys päätyä tietylle sivulle internetissä. Käytännössä Facebook, Twitter ja muut sosiaalisen median palvelut ovat kuitenkin muuttaneet tämän pelikentän täysin, koska esimerkiksi moniin Facebook-profiileihin Googlella ei ole mitään asiaa, ja myös Twitterissä on mahdollisuutta jakaa sisältöä ainoastaan tietyille käyttäjille. Tosin hakukoneet (ja vakoiluohjelmistot) voivat tarvittaessa ”kiertää” tätä ongelmaa keräämällä dataa käyttäjistä erilaisten työkalupalkkien avulla – ja Google myös omalla selaimellaan sekä esimerkiksi Google Analytics-ohjelmistolla ja Google+ palvelun avulla.

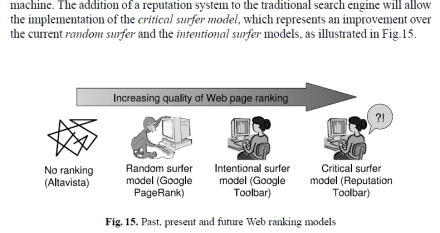

Audun Josang on tiivistänyt tätä ongelmaa oivallisesti artikkelissaan Trust and Reputation Systems, josta löytyy seuraava kuva:

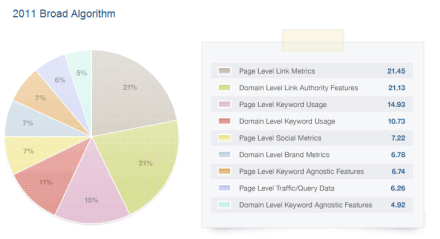

Internetin infrastruktuurien muutokset ovat siis suuri haaste hakukoneiden algoritmeille: epäilemättä on selvää että sosiaalisen median indikaattoreilla on merkitystä hakukonenäkyvyydelle. Seuraavassa on kuva siitä, mitkä ovat merkittävämmät tekijät sivuston hakukonenäkyvyydelle 2011. Paneeliin osallistui 132 hakukoneoptimoijaa maailman huipulta, ja kuvaa tarkastelemalla voidaan havaita että linkkien ja linkkivoiman merkitys näkyvyydelle on yhä kiistaton:

Linkkivoima 2012?

Vaikuttaa siltä, että linkkivoiman ohella käyttäjädatalla on jatkuvasti yhä suurempi vaikutus hakukonesijoituksiin, jolloin Josangin mukaan siirrytään yhä enemmän kohti ”kriittisen surffaajan” mallia:

Mitä tämä sitten käytännössä tarkoittaa? Sisällön ja matemaattisesti lasketun linkkivoiman lisäksi hakukonesijoituksiin vaikuttaa jatkossa yhä enemmän sellainen käyttäjädata, jota sekä analytiikalla että työkalupalkkien ja selainten avulla voidaan kerätä. Tällaisia asioita voivat olla esimerkiksi käyttäjien suositukset muille käyttäjille tai yksittäisten sivujen poistumisprosentit ja niiden suhde vastaaviin muihin sivuihin.

Voiko tekniikka muka parantaa hakukonesijoituksia?

Voi. Edellä on esitetty malleja ja lyhyt evoluutio Googlen algoritmin kehityksestä. Mitä enemmän algoritmin kehityksessä hyödynnetään käyttäjäkohtaista informaatiota, sitä suuremmaksi myös sivuston tekniikan osuus hakutuloksissa kasvaa.

Tässä 5 lyhyttä perustelua sille, miten ja miksi:

- HTML-kielen muutokset ja CSS-kielen kehittyminen mahdollistavat jo nyt huomattavasti aiempaa hakukone- ja käyttäjäystävällisemmät tavat tuottaa koodia

- Sivuston tekniikkaa optimoimalla voidaan lyhentää sivuston sivujen latautumisaikaa ja parantaa käyttäjäkokemusta

- Teknisillä muutoksilla voidaan tuoda sivulle käyttäjää kiinnostavaa sisältöä, kuten vaikkapa toisten samaa sivua lukeneiden käyttäjien selailemia muita sivuja esimerkiksi Google Analytics APIn välityksellä

- Luomalla tekniset edellytykset vaikkapa erilaisten snippettien (mikrodata, mikroformaatit, RDFa) käytölle voidaan parantaa sekä sivuston näkyvyyttä Googlen tuloksissa että myös Googlen käyttäjien kokemuksia

- Tekniikan avulla voidaan helpottaa Googlen työtä – esimerkkinä vaikkapa rel=”canonical” tai rel=”next” -tagit tuplasisällön tappajina

Mitä tästä seuraa?

Tekniikalla on aina ollut tärkeä rooli hakukoneoptimoinnissa. Jatkossa järkevät tekniset toteutukset voivat auttaa huomattavasti sivuston näkyvyyden kehittymistä, ja tekniikan jättäminen muiden toimenpiteiden jalkoihin tulee vaikeuttamaan hakutuloksien kärkijoukossa pysymistä. Mikäli markkinoinnista ja myynnistä halutaan täydet tehot irti, on korkea aika ottaa prosessiin mukaan myös webbisivuston tekniikka ja sen kehittäminen.

Tämä johdanto toimikoot nyt siis pieneä palopuheena myös markkinointi- ja myyntiväelle. Älkää unohtako tekniikkaa – milloin viimeksi ostitte webmasterille punaviinipullon? ;)

Johdanto on nyt saatu pois alta ja artikkelisarjan ensimäisessä osassa Levitä linkkivoima tehokkaasti päästään kiinni konkreettisiin esimerkkeihin siitä, kuinka tärkeäksi osoittautunutta linkkivoimaa voidaan levittää tehokkaasti edelleen. Jos haluatte syventää omaa ymmärtämystänne Googlen anatomiasta, niin suosittelen seuraavaa luettavaa:

PageRank Wikipediassa

The PageRank Citation Ranking (1999)

PageRank Sculpting vs. nofollow (SEOMoz 2009)

Google Webmaster Tools – asiaa snippeteistä

PS Lopuksi haluan kiittää Atte Tenkasta johdatuksesta Markovin ketjujen ja R-ohjelmointikielen pariin. Hyvää viikonloppua – ensi viikkoon!